Airflow

Airflow Datapipeline 툴이다.

과거에 사용하던 ETL과 유사하다.

대략 보아하니 얘는 MS SQL DTS와 유사하게 생겼다. DTS고 그 후손인 Integration Service고, Ozzie, Pentaho 모두 스타일은 비슷하다. SAS의 E-miner도 마찬가지이다. 서로 다른 소스의 데이터와 connection을 맺고, 변환이 이루어지고 스케쥴러들이 관리하는 형태이다.

요즘은 이러한 과정을 데이터 파이프라인이라고 부른다. R에서 명령어들 사이의 파이프라인 단축키를 치면 배치처럼 처리되었듯이 자동화가 요즘의 대세인듯 하다.

심지어 분석프로세스도 피드백과 반복을 위해 이러한 과정을 사용하고 있다.

도커를 먼저 실행한 후에

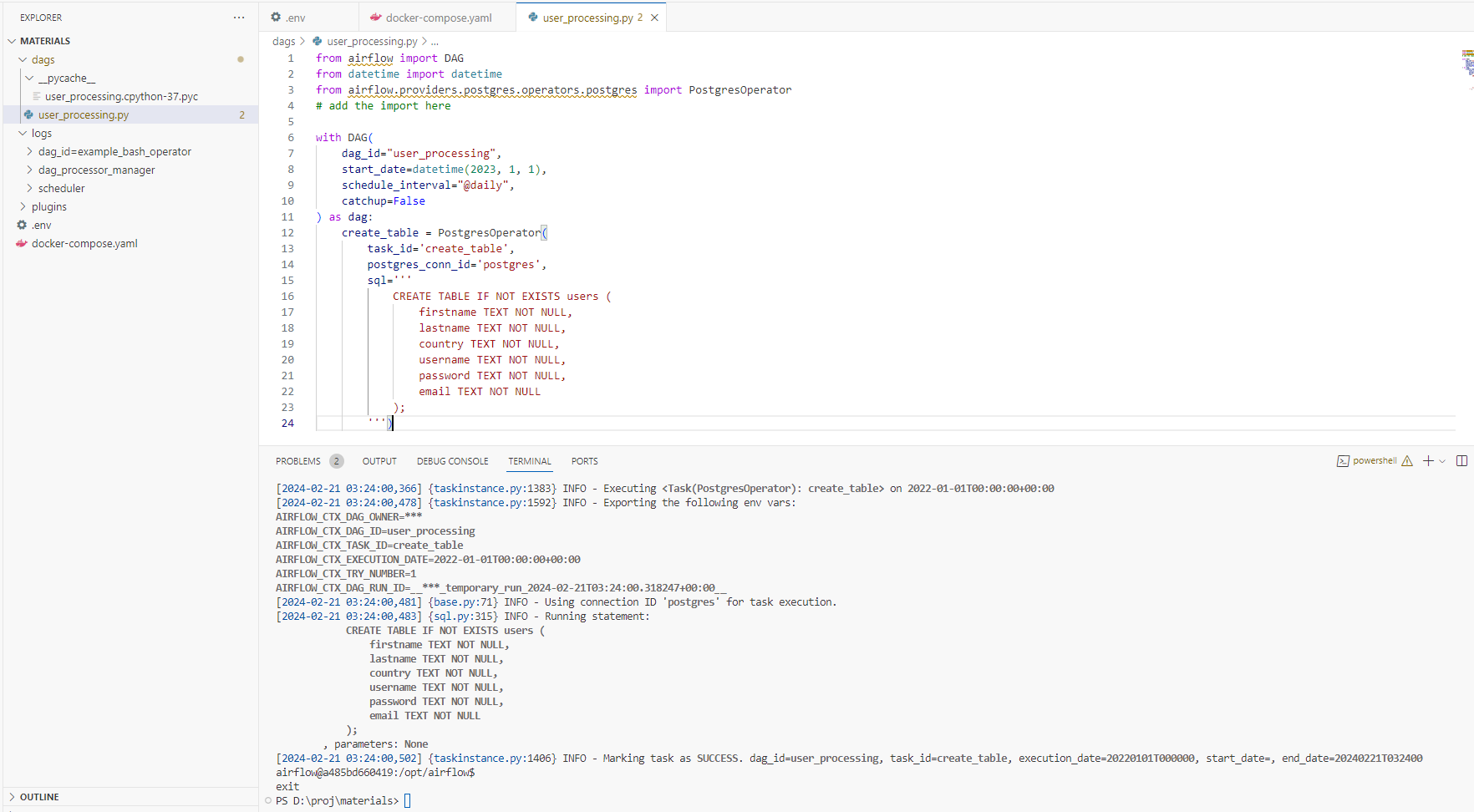

dag는 ETL의 Task, Flow와 유사하다.

docker-compose up -d으로 yml에 정의된 서비스를 시작한다.

docker-compose ps로 서비스를 살펴본다.

airflow -h 는 도움말을 부른다.

서비스 중에 임의로 실행하고 싶은 것이 있다면

docker exec -it 이름 /bin/bash를 입력하면 실행된다.

특정 dag를 실행하고자 한다면

airflow tasks test user_processing create_table 2023-01-01 로 실행해보면 테이블이 생성되는 것을 확인할 수 있다.

localhost:8080이다. 헷갈리지 않도록 주의

특정 dag를 만들었는데 왜 화면에 안나오냐고 모니터를 때리지 말자. 5분 정도 걸린다.